Esta questão é muito comum entre os amantes dos famosos NetBooks. O mais certo quando temos um computador com esta particularidade é termos uma drive externa de CDs. Mas existem ainda os casos em que a drive de CDs não funciona ou por algum motivo não temos uma drive externa.

Para estes casos temos alguns softwares que permitem instalar o Sistema Operativo numa Pen Drive e a partir da mesma formatar o computador.

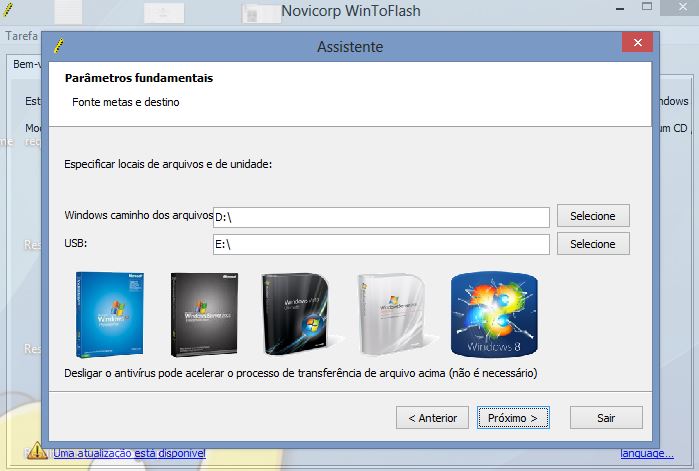

Nesta classe de softwares indicaria o “WinToFlash”.

Pré-requisitos:

- Ter o disco ou imagem com o sistema operativo (Windows nesse caso)

- Ter uma pendrive com espaço suficiente ( aproximadamente 1GB para o Windows XP e 4GB para o Windows Vista/7)

O passo seguinte é fazer o download do Win To Flash:

Depois do download, extraia o conteúdo para uma pasta e nem precisa de instalar, a execução é directa. Como foi citado no passo 1, é preciso ter uma cópia de CD, DVD ou arquivo ISO , em seguida usar o assistente do programa que servirá de guia até o pedido de confirmação do contrato de licença de cópia e em seguida irá formatar todo o conteúdo da sua PenDrive.

Caso tenha dificuldades, acompanhe o vídeo que demonstra o funcionamento do WinToFlash.

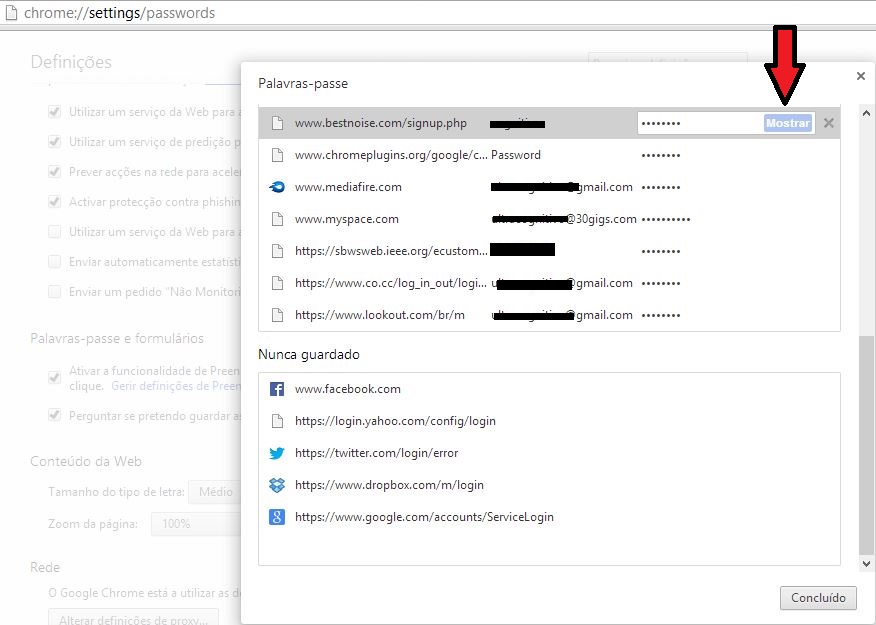

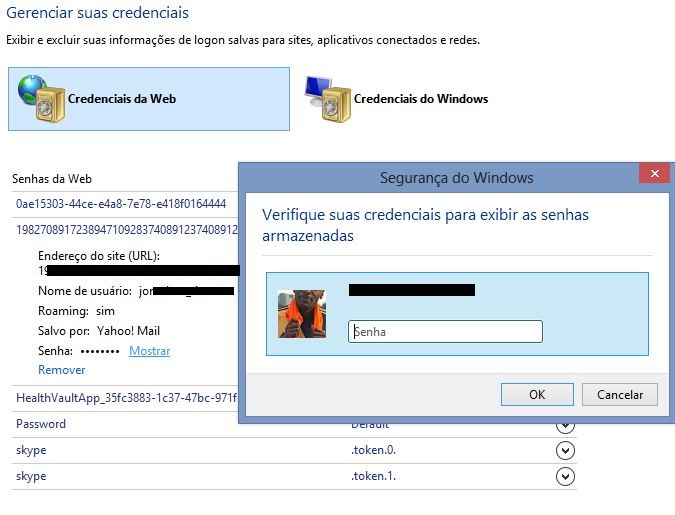

Mais imagens do aplicativo em acção: